前言:AI 视频生成的实时化挑战

在 AI 视频生成领域,从静态图像生成动态视频已经取得了长足的进步。然而,将这些技术应用到实时直播流中,依然面临着巨大的挑战。大多数现有的方案要么生成速度过慢,无法满足实时性要求;要么需要昂贵的硬件支持(如多张高端显卡),难以在普通用户的设备上运行。

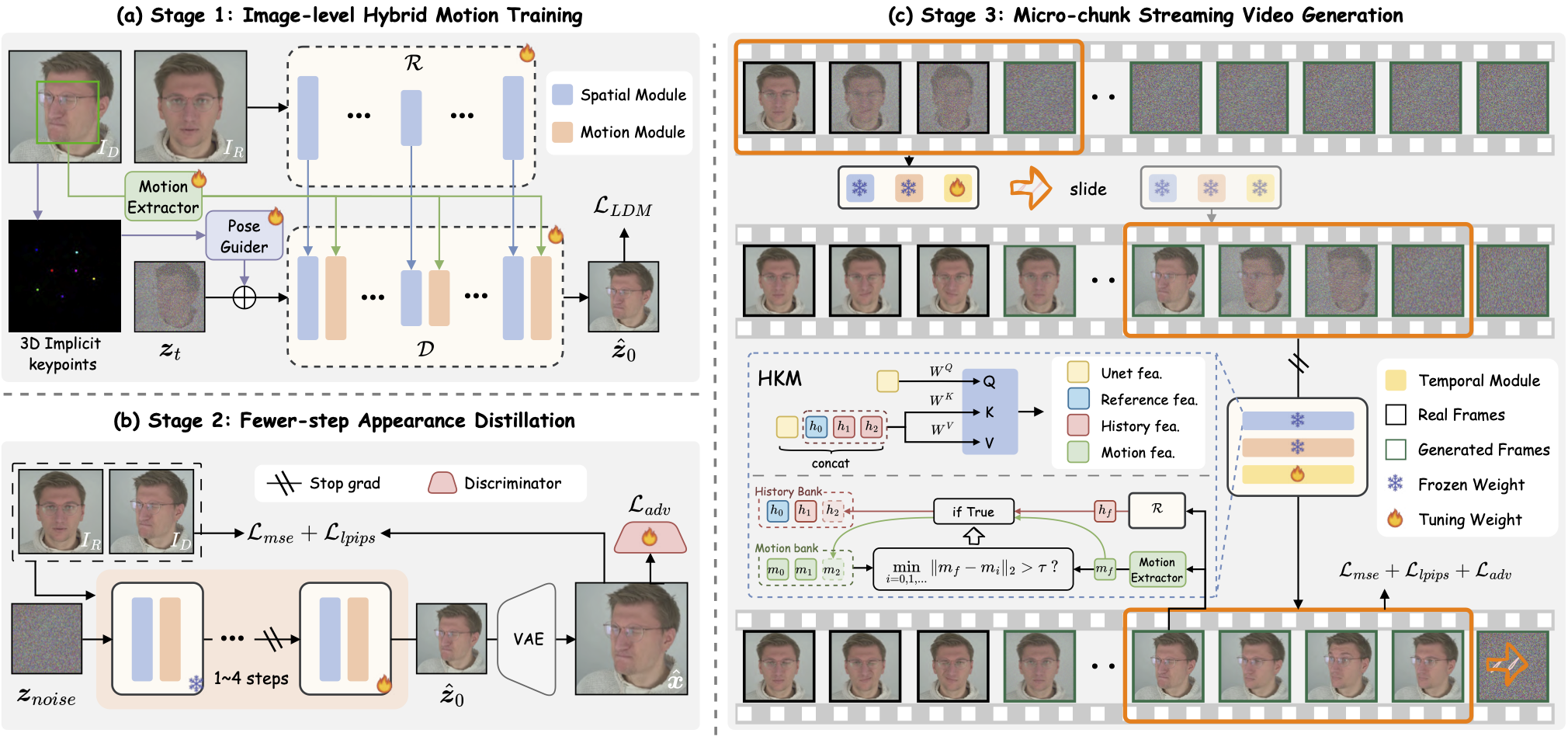

最近,来自 GVC Lab、澳门大学和 Dzine.ai 的研究团队发布了一个名为 PersonaLive 的开源项目,试图解决这一痛点。它是一个基于扩散模型的实时、可流式传输的肖像动画框架,旨在仅使用单张 12GB GPU 实现无限长度的肖像动画生成。

PersonaLive 的核心特性

根据其 GitHub 仓库(GVCLab/PersonaLive)的介绍,PersonaLive 主要具备以下特点:

- 实时流式处理 (Real-time & Streamable): 专为直播场景设计,能够以较低的延迟处理连续的视频流。

- 无限长度生成 (Infinite-Length): 框架设计支持持续生成动画,而不受短时序片段的限制。

- 低硬件门槛 (Single 12GB GPU): 相比许多需要 A100 或 H100 等高端显卡的模型,PersonaLive 优化了资源占用,使得更多普通用户也能体验和部署。

技术概览

PersonaLive 的架构融合了多个先进组件,旨在平衡生成质量与推理速度。

根据 README,该框架主要构建在以下开源项目的基础之上:

- Moore-AnimateAnyone

- X-NeMo

- StreamDiffusion

- RAIN

- LivePortrait

通过整合这些技术,PersonaLive 能够提取源图像的身份特征和驱动视频的运动信息,并将其融合生成最终的动画效果。

如何快速上手

如果你对 PersonaLive 感兴趣,可以按照以下步骤在本地部署和运行。

1. 环境安装

首先,你需要克隆仓库并创建一个 Python 3.10 的 Conda 虚拟环境。

BASH# 克隆仓库 git clone https://github.com/GVCLab/PersonaLive cd PersonaLive # 创建并激活环境 conda create -n personalive python=3.10 conda activate personalive # 安装依赖 pip install -r requirements_base.txt

2. 下载预训练权重

你需要下载基础模型和其他组件的权重。作者提供了多种下载方式,包括 Google Drive、百度网盘、阿里云盘以及 Hugging Face。

你可以运行项目提供的脚本自动下载(需要

gdown):BASHpython tools/download_weights.py

或者手动下载并放置在

./pretrained_weights 目录下。最终的目录结构应与 README 中描述的一致。3. 推理体验

PersonaLive 提供了两种推理模式:离线生成和在线(实时)生成。

离线推理 (Offline Inference)

如果你想测试单张图片和驱动视频的生成效果,可以使用离线脚本:

BASHpython inference_offline.py

注意: 如果你使用的是 RTX 50 系列显卡(Blackwell 架构),由于

xformers 暂未完全适配,可能会遇到崩溃问题。请使用以下命令禁用它:BASHpython inference_offline.py --use_xformers False

在线直播推理 (Online Inference)

这是 PersonaLive 的核心功能,用于实时流式传输。

-

搭建 Web UI:项目提供了一个基于 Node.js 的 Web 界面。你需要先安装 Node.js 18+,然后运行:BASH

cd webcam source start.sh -

加速(可选):为了获得更好的实时性能,可以将 PyTorch 模型转换为 TensorRT 格式,官方称这能带来约 2 倍的速度提升。转换过程可能需要 20 分钟左右。BASH

pip install -r requirement_trt.txt python torch2trt.py -

启动流式传输:BASH

python inference_online.py --acceleration none # 或者 xformers / tensorrt随后在浏览器中打开http://0.0.0.0:7860即可开始操作。

使用流程: 上传图片 -> 融合参考 -> 开始动画 -> 享受成果。

社区支持与兼容性

PersonaLive 发布不久,已经获得了一定的关注(GitHub Star 数约 500+),社区也非常活跃。

- Windows + RTX 50 系列支持:已有社区成员提供了在 Windows 系统及新款显卡上运行的详细指南。

- ComfyUI 集成:社区贡献者

okdalto已经开发了 ComfyUI-PersonaLive 节点,方便在 ComfyUI 工作流中调用。

总结

PersonaLive 为实时 AI 肖像动画提供了一个开箱即用的解决方案。它不仅降低了硬件门槛,还通过流式处理架构解决了无限时长生成的难题。对于希望在直播、虚拟主播或实时交互应用中引入 AI 动画能力的开发者来说,这是一个值得关注的开源项目。

项目地址: GVCLab/PersonaLive

相关论文: ArXiv:2512.11253